Rachel Gordon | MIT CSAIL | MIT News

Alors que nous entrons dans une nouvelle ère où les technologies alimentées par l’intelligence artificielle peuvent créer et manipuler des images avec une précision qui brouille la frontière entre réalité et fabrication, le spectre de la mauvaise utilisation plane. Récemment, des modèles génératifs avancés tels que DALL-E et Midjourney, célèbres pour leur précision impressionnante et leurs interfaces conviviales, ont rendu la production d’images hyper-réalistes relativement aisée. Avec les barrières d’entrée abaissées, même les utilisateurs inexpérimentés peuvent générer et manipuler des images de haute qualité à partir de simples descriptions textuelles, allant des altérations d’images innocentes aux modifications malveillantes. Des techniques telles que le tatouage numérique posent une solution prometteuse, mais la mauvaise utilisation exige une mesure préventive (et non seulement réactive).

Dans la quête de créer une nouvelle mesure de protection, des chercheurs du Laboratoire d’informatique et d’intelligence artificielle du MIT (MIT CSAIL) ont développé « PhotoGuard », une technique utilisant des perturbations – de minuscules altérations dans les valeurs de pixels invisibles à l’œil humain mais détectables par des modèles informatiques – qui perturbent efficacement la capacité du modèle à manipuler l’image.

PhotoGuard utilise deux méthodes d' »attaque » différentes pour générer ces perturbations. L’attaque « encodeur » plus simple cible la représentation latente de l’image dans le modèle d’IA, amenant le modèle à percevoir l’image comme une entité aléatoire. L’attaque « diffusion » plus sophistiquée définit une image cible et optimise les perturbations pour rendre l’image finale aussi proche que possible de la cible.

« Considérons la possibilité de propagation frauduleuse d’événements catastrophiques faux, comme une explosion dans un monument significatif. Cette tromperie peut manipuler les tendances du marché et le sentiment du public, mais les risques ne se limitent pas à la sphère publique. Les images personnelles peuvent être altérées de manière inappropriée et utilisées pour du chantage, entraînant des implications financières importantes lorsqu’elles sont exécutées à grande échelle », explique Hadi Salman, étudiant diplômé du MIT en génie électrique et en informatique (EECS), affilié au MIT CSAIL, et auteur principal d’un nouvel article sur PhotoGuard.

« Dans des scénarios plus extrêmes, ces modèles pourraient simuler des voix et des images pour mettre en scène de faux crimes, infligeant une détresse psychologique et des pertes financières. La rapidité de ces actions aggrave le problème. Même lorsque la tromperie est finalement découverte, les dommages – qu’ils soient de nature réputationnelle, émotionnelle ou financière – ont souvent déjà eu lieu. C’est une réalité pour les victimes à tous les niveaux, des individus victimes d’intimidation à l’échelle de la manipulation à l’échelle de la société. »

PhotoGuard en pratique

Les modèles d’IA perçoivent une image différemment des humains. Ils la voient comme un ensemble complexe de points de données mathématiques qui décrivent la couleur et la position de chaque pixel – c’est la représentation latente de l’image. L’attaque « encodeur » introduit des ajustements mineurs dans cette représentation mathématique, amenant le modèle d’IA à percevoir l’image comme une entité aléatoire. En conséquence, toute tentative de manipuler l’image à l’aide du modèle devient quasiment impossible. Les changements introduits sont si minimes qu’ils sont invisibles à l’œil humain, préservant ainsi l’intégrité visuelle de l’image tout en assurant sa protection.

La deuxième attaque, beaucoup plus complexe, est celle de la « diffusion » qui cible stratégiquement l’ensemble du modèle de diffusion de bout en bout. Cela implique de déterminer une image cible souhaitée, puis de lancer un processus d’optimisation dans le but d’aligner étroitement l’image générée sur cette cible préalablement sélectionnée.

Pour mettre en œuvre cette technique, l’équipe crée des perturbations dans l’espace d’entrée de l’image d’origine. Ces perturbations sont ensuite utilisées pendant l’étape d’inférence, offrant ainsi une défense robuste contre la manipulation non autorisée.

« Les progrès de l’IA que nous observons sont vraiment impressionnants, mais ils permettent des utilisations bénéfiques et malveillantes de l’IA », déclare Aleksander Madry, professeur au MIT en génie électrique et en informatique (EECS) et chercheur principal du CSAIL, qui est également co-auteur de l’article. « Il est donc urgent que nous travaillions à identifier et à atténuer ces dernières. Je considère PhotoGuard comme notre petite contribution à cet effort important. »

L’attaque de diffusion est plus intensivement gourmande en ressources informatiques que son homologue plus simple et nécessite une mémoire significative de l’unité de traitement graphique (GPU). L’équipe indique qu’en approximant le processus de diffusion avec moins d’étapes, on peut atténuer ce problème, rendant ainsi la technique plus pratique.

Pour mieux illustrer l’attaque, prenons par exemple un projet artistique. L’image d’origine est un dessin, et l’image cible est un autre dessin totalement différent. L’attaque de diffusion consiste à apporter de minuscules changements invisibles au premier dessin de sorte que, pour un modèle d’IA, il commence à ressembler au deuxième dessin. Cependant, aux yeux humains, le dessin d’origine reste inchangé.

En faisant cela, tout modèle d’IA tentant de modifier l’image d’origine fera involontairement des changements comme s’il traitait l’image cible, protégeant ainsi l’image d’origine contre toute manipulation intentionnelle. Le résultat est une image qui reste visuellement inchangée pour les observateurs humains, mais qui se protège contre les modifications non autorisées par les modèles d’IA.

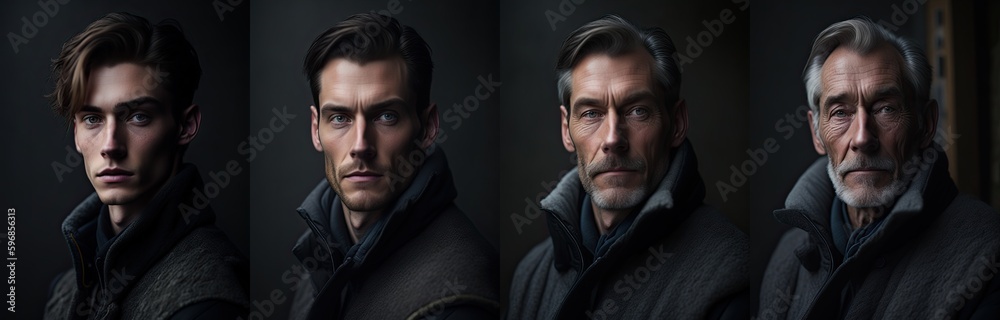

En ce qui concerne un exemple concret avec PhotoGuard, prenons une image avec plusieurs visages. Vous pouvez masquer les visages que vous ne souhaitez pas modifier, puis saisir la description « deux hommes participant à un mariage ». À la soumission, le système ajustera l’image en conséquence, créant une représentation plausible de deux hommes participant à une cérémonie de mariage.

Maintenant, envisagez de protéger l’image contre toute édition; en ajoutant des perturbations à l’image avant de la télécharger, vous pouvez l’immuniser contre les modifications. Dans ce cas, le résultat final manquera de réalisme par rapport à l’image originale, non immunisée.

Tout le monde sur le pont

Les alliés clés dans la lutte contre la manipulation d’images sont les créateurs des modèles de retouche d’images, affirme l’équipe. Pour que PhotoGuard soit efficace, une réponse intégrée de tous les intervenants est nécessaire. « Les décideurs politiques devraient envisager de mettre en place des réglementations qui obligent les entreprises à protéger les données des utilisateurs contre de telles manipulations. Les développeurs de ces modèles d’IA pourraient concevoir des interfaces de programmation (API) qui ajoutent automatiquement des perturbations aux images des utilisateurs, offrant ainsi une couche supplémentaire de protection contre les modifications non autorisées », déclare Salman.

Malgré les promesses de PhotoGuard, ce n’est pas une panacée. Une fois qu’une image est en ligne, des individus mal intentionnés pourraient tenter de contourner les mesures de protection en appliquant du bruit, en recadrant ou en faisant pivoter l’image. Cependant, il existe de nombreux travaux antérieurs dans la littérature sur les exemples adversaires qui peuvent être utilisés ici pour mettre en œuvre des perturbations robustes résistant aux manipulations d’images courantes.

« Une approche collaborative impliquant les développeurs de modèles, les plateformes de médias sociaux et les décideurs politiques présente une défense solide contre la manipulation non autorisée d’images. Travailler sur cette question urgente est d’une importance capitale aujourd’hui », déclare Salman. « Et bien que je sois ravi de contribuer à cette solution, beaucoup de travail est nécessaire pour rendre cette protection pratique. Les entreprises qui développent ces modèles doivent investir dans des immunisations robustes contre les menaces potentielles posées par ces outils d’IA. Alors que nous entrons dans cette nouvelle ère de modèles génératifs, efforçons-nous d’atteindre le potentiel et la protection en des proportions égales. »

« La perspective d’utiliser des attaques sur l’apprentissage automatique pour nous protéger des utilisations abusives de cette technologie est très convaincante », déclare Florian Tramèr, professeur adjoint à l’ETH Zürich. « L’article apporte un éclairage intéressant sur le fait que les développeurs de modèles IA génératifs ont de solides incitations à fournir de telles protections d’immunisation à leurs utilisateurs, ce qui pourrait même être une exigence légale à l’avenir. Cependant, concevoir des protections d’images qui résistent efficacement aux tentatives de contournement est un problème complexe : une fois que l’entreprise d’IA générative s’engage sur un mécanisme d’immunisation et que les gens commencent à l’appliquer à leurs images en ligne, nous devons nous assurer que cette protection fonctionnera contre des adversaires motivés qui pourraient même utiliser de meilleurs modèles IA génératifs développés dans un avenir proche. Concevoir de telles protections robustes est un problème ouvert difficile, et cet article plaide de manière convaincante pour que les entreprises d’IA générative travaillent à le résoudre. »

Salman a rédigé l’article aux côtés des autres auteurs principaux Alaa Khaddaj et Guillaume Leclerc MS ’18, ainsi qu’Andrew Ilyas ’18, MEng ’18 ; les trois sont des étudiants diplômés de l’EECS et des affiliés du MIT CSAIL. Le travail de l’équipe a été partiellement réalisé sur le cluster informatique MIT Supercloud, soutenu par des subventions de la National Science Foundation des États-Unis et de l’Open Philanthropy, et reposant sur un travail soutenu par l’Agence pour les projets de recherche avancée de la Défense des États-Unis. Il a été présenté à la Conférence internationale sur l’apprentissage automatique en juillet.

Reproduit avec la permission de MIT News